其實我覺得從先前ATi先前的一個****辭"

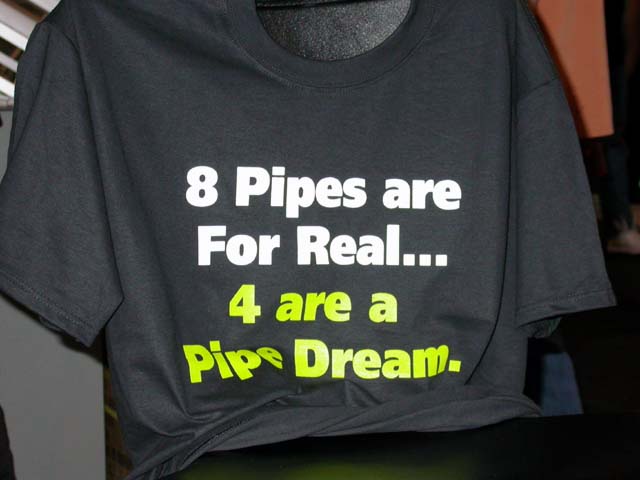

8pipes are for REAL.... 4 are a pipedream", 就可以看出NV3x的最大問題:

先不管它中不中用, 至少它不中看.... 是一個在宣傳上很吃虧的東西.

好棒的T恤. XD

nVIDIA自己身體力行了好一陣子的暴力法, 宣傳著fillrate is everything的理念; 但是到了NV3x, 我們可以看到NV30/31/34/35通通都是4pixel/cycle的架構, fillrate輸出能力都是同等的, 主要的差異都在Shader Executive Resource方面. (NV30 = 4/3 x NV31 = 2 x NV34), 而且還不會直接等效到執行效能差異上頭. NV35更是只有加強FP32的執行效能, FP16則沒有改變, 我們還沒提到DX9底下沒有辦法用FP32, 只有FP16可以用....(目前看起來128bit只能在OpenGL下使用, 這是先前看到的實測結果)

就像先前PCWatch的後藤大叔說的, 說難聽點, ATi現在才是暴力法的奉行者.... 在我眼中R300才像是過去NV2x架構理念的後繼者, NV3x這麼詭異的架構真的簡直是在賞自己耳光. (棄奉行多年的暴力法為鄙屣)

NV3x是完全不同的理念. 要說起來NV3x整個實作性質上還比較接近3Dlabs P10.(Scalable Shader Array), 處理單元在晶片內部形成陣列, 高階晶片的Shader單元數量最多, 要出中階低階只要砍單元數量就好. 雖說P10當時主要的企圖是想透過compiler技術進一步提高管線執行效率, 當然NV3x因為有同樣性質的實作, 也具有同樣的優勢; 相對地, P10也有NV3x這樣可以很快部署高中低階產品的效果存在, 3Dlabs宣稱當初P10的簡化版P9的設計, 只花了兩個禮拜就搞定了, 架構設計可以說只做了一次, 成本管理上差距天差地遠,

反過來說, R8500 和 R9000 之間的差異並不大, 但是ATi可是幾乎從頭去刻這個晶片.... 搞著搞著可能ATi真的怕了, 現在 R300 和 R350之間沒啥差異, 只有整個晶片作徹底Custom Optimize, 不過花的功夫只怕旁人也難以想像. 總之R200時代帶來的反動就是現在傳聞R360和R390, 直到R420都是同樣的玩意兒不斷地在最佳化.... 直到 R500才會是新的架構. 只怕到時候ATi也開始玩nVIDIA/3Dlabs的這一套.

要強調的事情是, 暴力法是有極限的. 因為我們知道, 即使理論fillrate再高, 都會因為pipeline管線中其他地方造成瓶頸, 而無法實際發揮出來, 比如說即使是現在開始拋售的爛玩意兒, GF4Ti系列,即使是Ti4200都有4pipes x 250MHz = 1Gpixel/s, 這可是有辦法在1600x1200的解析度下跑出520FPS的鬼玩意兒; 更別提R9700啦, 那可是8pipe, FPS會破1K的.... 實際上呢? 我們知道, 瓶頸根本就不在那個地方; 那麼不如務實地追求Shader Performance還比較好不是嗎?

而且產品線的推展成本也變低了, 目前NV31Ultra最終版的時脈是400/800, 不管是fillrate和Memory Bandwidth都和NV30NU同等(1.6Gpixel/s & 12.8GB/s); 但是效能還是有差異. 因為內部的處理單元數量的確有差異, 架構本身已經等於考慮好產品區隔了, 能只做一次的事情就不應該做兩次.

只可惜, 現在根本就沒有啥DX9的遊戲, 甚至DX8的遊戲才剛開始普及, 隨便用個PS2.0的Shader就可以打著DX9遊戲的大旗了, NV3x這樣的架構在宣傳上實在是非常的不利, 看到ATi拿出"8pipes are for REAL.... 4 are a pipedream"字樣的T恤出來, nVIDIA的廣報部門當然是只能鬼扯了....

先不要提FP32和FP16環境上的問題, 即使12bit Int的品質之高令人驚艷, 連John Carmack大神都稱讚; 但是在宣傳上12bit Int一定是矮24bit FP一截, 偏偏就算是現行CRT也很難看出12bit Int與24bitFP的差異----目前市面上LCD目前頂多8bit, 256階, CRT則普遍可以顯示出約三百多階的色階差異, 但是

12bit可是4096階.... 透過現行顯示週邊, 用肉眼看得出來才有鬼.

當初Beyond3D貼出3DMark03部分有問題截圖的時候, 有人指出可以"明顯看出"(apperently)因為用了FP16, 使得品質低於24bit的R300; 但是其實即使真的有差異, 因為CRT的限制, 肉眼也絕對看不出來; 除非你拿軟體去分析才會有結果, 肉眼則絕對看不出有差異.

那現在的這麼一大團烏煙瘴氣到底是什麼?

最主要的問題還是在於軟體方面. 像P10/NV3x這樣的架構效能維繫在Compiler Optimize, 塞給它傳統的 Shader 一定沒辦法發揮它的效能, 但是其實因為各種宣傳手法的關係, Optimize和Adaptec之類的字樣濫用得很厲害, 害消費者現在都搞不清楚了.

比如說本討論串前面giligula兄所言,

引用:

你要是有把玩過那個程式的話

就會知道 ATI 的 filtering 模式是會對所有角度都做 filtering

但是某些角度只做 4x

不過遊戲中常遇到的角度還是 16x

實際上根本就不太可能看出差別

|

實際上呢?

它的確是把16x在部分狀況下改成了4x, 去減低了部分的執行負擔, 改動到了benchmark程式本身既定的工作量, 這是無庸置疑的事實, 難道不能算是一種作弊?

看不看得出來? 說實在地, 這本身就是個見仁見智的問題. (至少不像先前12bit Int vs 24bit FP, 這是肉眼就可以分辨的) 還先不要提先前我還聽過有人覺得用十字樹算作弊哩(雖說是TV-Game Console那頭的話題), 難不成要一片一片刻樹葉嗎?! 笑話.

當然, NVIDIA這回整個把人家的Shader換掉這件事情我認為絕對是不可原諒的; 不過我舉個別的例子好了, 知名Benchmark suite--SPEC2000

本身允許CPU製造商自己透過compiler去將同一組程式碼對自己的CPU做optimize, 那請問這算不算是默許作弊?實際上是SPEC對Optimize這件事情的尺度在哪邊早已有很完整的定義, 目前在顯示晶片市場明顯地缺乏這方面的機制存在. 還有HLSL本身就還在草創時期也是個很大的問題....

總之我覺得, 現在的亂象當初CPU市場已經經歷過了, 還需要時間讓顯示市場來調適....